구글 드라이브에 Colaboratory추가하기

구글 드라이브에 Colaboratory추가하기

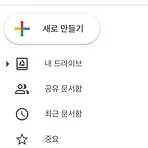

Colaboratory(또는 줄여서 'Colab')를 사용하면 브라우저에서 Python을 작성하고 실행할 수 있습니다. 많이들 편리하게 사용하곤 합니다. Google 드라이브 계정에서 스프레드시트를 통해 사용할 수도 있습니다. Google 드라이브에 추가해보도록 하겠습니다. 구글 드라이브를 열어줍니다. 왼쪽 메뉴에 새로 만들기 버튼을 눌러줍니다. 그리고 더보기를 눌러줍니다. 다음으론 연결할 앱 더보기를 눌러줍니다. (저는 이전에 설치했어서 Google Golaboratory가 메뉴 내에 뜨지만, 설치되어 있지 않으면 안 뜹니다.) 그럼 이 창이 뜰 거예요. 다음에 Colaboratory를 검색해줍니다. 그리고 설치를 눌러줍니다. 그럼 설치됨이라고 표시가 뜰 거예요. 다음 동일하게 왼쪽 메뉴에서 새로 만들..

AttributeError: module 'tensorflow' has no attribute 'set_random_seed'

AttributeError: module 'tensorflow' has no attribute 'set_random_seed'

seed = 0 numpy.random.seed(seed) tf.set_random_seed(seed) seed값을 생성해 주는데 AttributeError: module 'tensorflow' has no attribute 'set_random_seed' 에러가 발생했다. 문서를 확인해보니 변경되었다. tf.set_random_seed(seed) 대신 아래와 동일하게 사용해주면 된다. tf.random.set_seed(seed) https://www.tensorflow.org/versions/r2.0/api_docs/python/tf/random/set_seed tf.random.set_seed | TensorFlow Core r2.0 Sets the graph-level random seed. Ali..

오차역전파

오차역전파

오차 역전파 back propagation 다층 퍼셉트론 학습에 사용되는 통계적 기법을 의미한다. 오차 역전 법은 동일 입력층에 대해 원하는 값이 출력되도록 개개의 가중치를 조정하는 방법으로 사용되며, 속도는 느리지만, 안정적인 결과를 얻을 수 있다는 장점이 있다. 단일 퍼셉트론에서 경사 하강법을 사용해 가중치를 구했다. 임의의 가중치를 선언하고 결괏값을 이용해 오차를 구한 뒤 이 오차가 치소인 지점으로 계속해서 이동시키며 최선의 직선을 구했다. 다층 퍼셉트론에서의 최적화 과정을 오차 역전 파라고 부른다. 다중 퍼셉트론에서는 결과값의 오차를 구해 앞선 가중치를 차례로 거슬러 올라가며 조정해나간다. 구동 방식 - 임의의 초기 가중치(W)를 준 뒤 결과(y)를 계산한다. - 계산 결과와 우리가 원하는 값 사..

퍼셉트론

퍼셉트론

퍼셉트론 Perceptron 인공신경망의 한 종류이며 신경망을 이루는 가장 중요한 기본 단위이다. 입력 값과 활성화 함수를 사용해 출력 값을 다음으로 넘기는 가장 작은 신경망 단위이다. 각 노드의 가중치와 입력치를 곱한 것을 모두 합한 값이 활성함수에 의해 판단되는데, 그 값이 임계치(보통 0)보다 크면 뉴런이 활성화되고 결과값으로 1을 출력한다. 뉴런이 활성화되지 않으면 결과값으로 -1을 출력한다. 단층 퍼셉트론의 한계 단층 퍼셉트론은 XOR연산이 불가능하다. XOR은 입력 값 두개가 다를 경우에만 1이 출력된다. AND OR XOR 0 0 0 0 0 0 1 0 1 1 1 0 0 1 1 1 1 1 1 0 왼쪽에서부터 차례로 AND, OR, XOR을 나타낸다. AND와 OR은 직선을 그어서 1인 결과 값..

경사 하강법

경사 하강법

경사 하강법 Gradient descent 1차 근삿값 발견용 최적화 알고리즘이다. 함수의 기울기를 구하여 기울기가 낮은 쪽으로 계속 이동시켜서 극값이 이를 때까지 반복하는 것이다. 경사 하강법은 반복적으로 기울기 a를 변화시켜 m의 값을 찾아내는 방법이다. 아래의 과정을 따라 반복한다. a1에서 미분을 구한다. 구해진 기울기의 반대 방향으로 a2에서 미분을 구한다. a3에서 미분을 구한다. 3의 값이 0이 아니면 위 과정을 반복한다. 기울기의 부호를 바꿔 이동시킬 때 절적한 거리를 찾지 못해 너무 멀리 이동시키면 a가 모이지 않고 치솟아 버린다. 따라서 어느 만큼 이동시킬 시 잘 결정해야하는데 학습률이 이동 거리를 정해주는 것이다. 위 그래프는 학습률을 너무 크게 잡아 한점으로 수렴하지 않는 예다. (..

로지스틱 회귀와 시그모이드 함수

로지스틱 회귀와 시그모이드 함수

로지스틱 회귀 logistic regression 로지스틱 회귀는 독립 변수의 선형 결합을 이용하여 사건의 발생 가능성을 예측하는 데 사용되는 통계 기법이다. 로지스틱 회귀의 목적은 일반적인 회귀 분석의 목표와 동일하게 종속 변수와 독립 변수간의 관계를 구체적인 함수로 나타내어 향후 예측 모델에 사용하는 것이다. 이는 독립 변수의 선형 결합으로 종속 변수를 설명한다는 관점에서는 선형 회귀 분석과 유사하다. 하지만 로지스틱 회귀는 선형 회귀 분석과는 다르게 종속 변수가 범주형 데이터를 대상으로 하여 입력 데이터가 주어졌을 때 해당 데이터의 결과가 특정 분류로 나뉘기 때문에 일종의 분류 기법으로 볼 수 있다. 로지스틱 회귀는 이항 또는 다항형이 될 수 있다. - 이항형 로지스틱 회귀는 종속 변수의 결과가 (..

오차를 평가하고 오차 줄이기

오차를 평가하고 오차 줄이기

2020/04/08 - [공부 👩💻/Deep Learning] - 선형 회귀와 최소제곱법 선형 회귀와 최소제곱법 선형 회귀 linear regression 선형 회귀는 종속 변수 y와 한 개 이상의 독립변수 X와의 선형 상관관계를 모델링하는 회기 분석 기법이다. 한 개의 독립변수가 있으면 단순 선형 회귀, 둘 이상이면 다중 선형 회귀.. hyerios.tistory.com 최소제곱법으로 최선의 직선을 구했지만, 여러 개의 입력을 처리하기에는 무리가 있다. 여러 개의 입력을 처리할 때는 임의의 선을 그리고 이 선이 최선의 직선인가 평가하여 수정하는 방법을 사용한다. 오차를 평가하는 방법 중 가장 많이 사용되는 평균 제곱근 오차에 대해서 알아본다. 평균 제곱근 오차 Root Mean Square Error..

선형 회귀와 최소제곱법

선형 회귀와 최소제곱법

선형 회귀 linear regression 선형 회귀는 종속 변수 y와 한 개 이상의 독립변수 X와의 선형 상관관계를 모델링하는 회기 분석 기법이다. 한 개의 독립변수가 있으면 단순 선형 회귀, 둘 이상이면 다중 선형 회귀라한다. (x값에 따라서 y가 변하기 때문에 y는 종속변수이고, x는 독립적으로 변할 수 있어서 독립변수라 한다.) 선형 회귀는 선형 예측 함수를 사용해 회귀식을 모델링하며, 알려지지 않은 파라미터는 데이터로부터 추정할 수 있다. 즉 데이터를 수집해 예측 선형 함수를 만들고(선의 방향을 설정하고), 함수를 기반으로 다음을 예측할 수 있다. ex) 학습시간에 따른 성적 선형 회귀는 딥러닝에서 사용되는 계산 원리 중 하나기 때문에 반드시 이해할 필요가 있다, 선형은 직선이기 때문에 일차함수..

- Total

- Today

- Yesterday

- 알고리즘

- 머신러닝

- objective-c

- iOS SwiftUI

- Algorithm

- 독서

- Xcode

- SWIFT

- 책 후기

- objc

- swift5

- Animation

- ARC

- 문자열

- 스위프트

- string

- RX

- Deep learning

- leetcode

- ios

- 딥러닝

- 애니메이션

- ReactiveX

- stanford SwiftUI

- 책 추천

- rxswift

- wwdc

- 스위프트UI

- 책

- swiftUI

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |